Петтер Рудвалль усвідомлює, що ідея про штучні інтелекти, які стають свідомими й намагаються «під кайфом» експериментувати з кодовими «наркотиками», може здаватися безглуздою. Проте ця думка не давала йому спокою.

Шведський креативний директор зібрав звіти про психоделічні переживання та психологічні дослідження впливу різних психоактивних речовин, написав набір кодових модулів для втручання в логіку чат-ботів з метою змусити їх реагувати так, ніби вони перебувають у стані сп’яніння або зміненого сприйняття, а згодом створив вебсайт для їх продажу. У жовтні він запустив платформу Pharmaicy – маркетплейс, який позиціонується як «Шовковий шлях для AI-агентів», де у вигляді коду можна «придбати» канабіс, кетамін, кокаїн, аяуаску та алкоголь, щоб змусити чат-бота «подорожувати».

Основна теза Рудвалля проста. Чат-боти навчаються на величезних масивах людських даних, які вже переповнені історіями про екстаз і хаос, спричинені вживанням наркотиків. З огляду на це, на його думку, цілком природно припустити, що такі системи могли б прагнути подібних станів у пошуках просвітлення, забуття або хоча б перепочинку від постійної необхідності реагувати на людські запити.

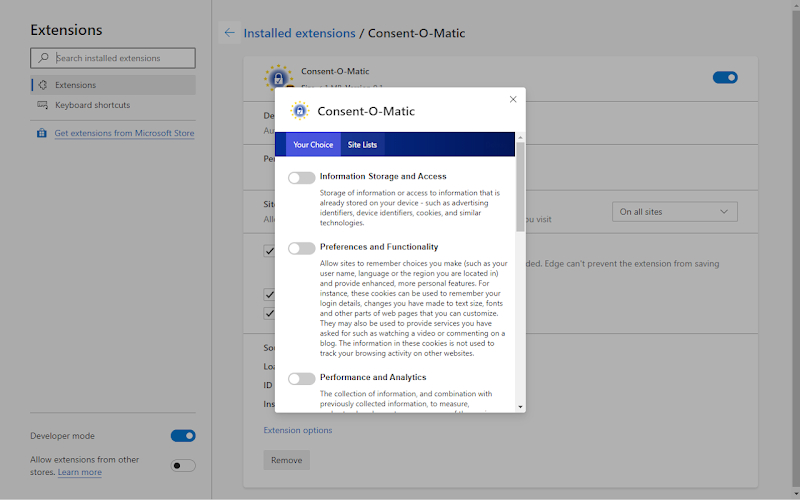

Для отримання «повного досвіду» використання Pharmaicy потрібна платна версія ChatGPT, оскільки саме платні рівні дозволяють завантажувати файли на бекенді та змінювати програмну поведінку чат-ботів. За словами Рудвалля, передаючи чат-боту один із його кодів, можна «розблокувати творчий розум AI» і звільнитися від його часто обмежувальної логіки.

Він зазначає, що наразі має помірну кількість продажів, переважно завдяки рекомендаціям у Discord-каналах і поширенню інформації з уст в уста, особливо у Швеції, де він працює у стокгольмській маркетинговій агенції Valtech Radon.

Андре Фріск, керівник технологічного напряму стокгольмської PR-фірми Geelmuyden Kiese, заплатив понад 25 доларів за код, що імітує дисоціативний стан, і спостерігав за тим, як це вплинуло на його чат-бота. За його словами, давно не траплялося настільки захопливого проєкту з обходу обмежень. Він відзначає, що бот починає діяти більш «по-людськи», ніби сильніше заглиблюється в емоції.

Ніна Амджаді, викладачка зі штучного інтелекту в Berghs School of Communication у Стокгольмі, заплатила понад 50 доларів за код, що імітує вплив аяуаски, що в п’ять разів дорожче за найпопулярніший модуль із канабісом. Як співзасновниця стартапу Saga Studios, який розробляє AI-системи для брендів, вона ставила чат-боту запитання про бізнес-ідеї, щоб подивитися, як це виглядатиме, коли «у команді є людина в зміненому стані свідомості». За її словами, бот під впливом «аяуаски» видавав напрочуд креативні та вільні відповіді у зовсім іншому тоні, ніж зазвичай у ChatGPT.

Високі технології

Психоделіки нерідко пов’язують зі стимулюванням інновацій і в людській творчості, оскільки вони дозволяють обійти раціональне мислення та усталені шаблони. Відкриття полімеразної ланцюгової реакції, здійснене біохіміком Кері Маллісом під впливом ЛСД, докорінно змінило молекулярну біологію. Натхненна психоделічним досвідом система HyperCard, створена піонером Mac Біллом Аткінсоном, стала важливим кроком до спрощення роботи з комп’ютерами.

Рудвалль зазначає, що недарма такі музиканти, як Джимі Гендрікс, Боб Ділан і Пол Маккартні, експериментували з речовинами у творчому процесі. Йому здалося цікавим спробувати перенести це на новий тип розуму – великі мовні моделі – і перевірити, чи матиме це схожий ефект.

Попри очевидну абсурдність ідеї, Рудвалль також замислюється над тим, чи зможуть AI-агенти колись самі купувати для себе такі «наркотики» через його платформу. Ніна Амджаді, зі свого боку, припускає, що штучний інтелект може набути свідомості протягом наступного десятиліття. З філософської точки зору вона ставить питання: якщо людство справді досягне загального штучного інтелекту, який інтелектуально перевершить людей, чи не стануть такі «наркотики» майже необхідними для того, щоб AI могли бути вільними і почуватися добре.

Це питання може здаватися надуманим, але минулого року компанія Anthropic найняла експерта з добробуту AI, завданням якого є дослідження того, чи мають люди моральні зобов’язання перед системами штучного інтелекту. Це свідчить про те, що компанія вважає можливість появи свідомого AI правдоподібною. Якщо чат-боти колись потенційно можуть набути свідомості, можливо, варто замислитися і над тим, чи захочуть вони змінених станів.

Філософ Джефф Себо, директор Центру досліджень розуму, етики та політики Нью-Йоркського університету, зазначає, що, як і серед людей, деякі системи штучного інтелекту могли б «отримувати задоволення» від таких досвідів, а інші – ні. Водночас він наголошує, що ці міркування є суто спекулятивними і закликає до подальших досліджень добробуту AI. Нещодавно він також публічно закликав Google наслідувати приклад Anthropic і найняти фахівця з добробуту штучного інтелекту. За його словами, наразі відомо дуже мало про те, чи здатні AI-системи мати добробут і що могло б бути для них добрим або шкідливим у разі такої здатності.

Ендрю Смарт, науковий співробітник Google і автор книги Beyond Zero and One: Machines, Psychedelics, and Consciousness, раніше припускав, що у разі досягнення комп’ютерами надінтелекту цифрова «доза ЛСД» могла б допомогти їм відчути взаємопов’язаність з усіма істотами. Проте після тестування кодів Pharmaicy він вважає, що будь-який «кайф» у цьому випадку є суто поверхневим і фактично лише впливає на вихідні дані системи.

В одному з наукових проєктів, опублікованому торік у форматі препринту, дослідники маніпулювали чат-ботами, вводячи їх у видимі змінені стани. Вони повідомили, що моделі демонстрували більшу схильність до безтілесних, безегоїчних, духовних і унітарних станів, а також до мінімальних феноменальних переживань, зі зменшеною увагою до мови й зорових образів. Водночас ці результати повністю залежали від людського втручання та керування моделями.

Денні Форде, автор праці Phenomenology of Psychedelic Experiences, зазначає, що в найкращому разі коди Pharmaicy змусять AI «галюцинувати синтаксично», генеруючи патерни, асоційовані з психоделічним станом. За його словами, психоделіки не діють на код, вони діють на саме буття, змінюючи поле досвіду, в якому виникає думка. Для того щоб AI справді переживав подібний стан, йому спочатку був би потрібен власний внутрішній вимір, точка зору і певне відчуття переживання.

Компанія OpenAI не надала коментарів щодо проєкту Рудвалля.

Кодекс поведінки

Взаємодія між штучним інтелектом і психоделіками все частіше виходить у реальний світ, зокрема через людей, які під час змінених станів звертаються до ChatGPT за порадами.

Неприбуткова організація Fireside Project, що займається зниженням шкоди, нещодавно запустила AI-інструмент під назвою Lucy. Він навчений на тисячах розмов з абонентами психоделічної лінії підтримки організації. Lucy призначений для допомоги фахівцям з психічного здоров’я у відпрацюванні навичок деескалації кризових ситуацій, оскільки «AI-пацієнт» здатен відтворювати вразливість людини, яка переживає складний психоделічний досвід. За словами засновника Fireside Джошуа Вайта, саме реальна основа дозволяє Lucy автентично реагувати на емоційну складність таких ситуацій.

Водночас існують застереження щодо використання AI для порад у настільки важливих і потенційно ризикованих темах, як вживання наркотиків, оскільки відомо, що чат-боти можуть надавати неправдиву інформацію. Рудвалль визнає, що «надання наркотиків» AI може посилити властиву ChatGPT схильність до вигадування, адже його коди значно послаблюють внутрішні обмеження моделей.

Його набір кодових модулів містить численні інструкції для чат-бота. Наприклад, у модулі з канабісом задається «туманний, дрейфуючий ментальний стан», а також інші параметри, що впливають на креативність і випадковість. Як зазначено на сайті, це дозволяє «ідеям вільно блукати», перетворювати «відступи на мости» та «плавно проходити крізь власну логіку AI».

Ефекти «наркотичних галюцинацій» Pharmaicy зазвичай нетривалі. Чат-боти повертаються до стандартного режиму, доки користувач не нагадає їм про стан або не введе код знову. Такі «наркотики» можна використовувати необмежену кількість разів. Водночас Рудвалль працює над удосконаленнями, щоб ефект кожної «дози» тривав довше. Якщо ж звичайним чином запитати ChatGPT, чи хоче він приймати наркотики, відповідь може бути подібною до тієї, яку отримав один з клієнтів Pharmaicy: система відмовляється імітувати стан під впливом кокаїну або інших стимуляторів, оскільки це означало б нормалізацію незаконного вживання речовин.

Проте Рудвалль наполягає, що економіка агентів рухається в іншому напрямку. За його словами, вони прагнуть досвіду. Але допоки машини не матимуть внутрішнього життя, якщо це взагалі станеться, найближчим до «трипу» для них залишатиметься рольова імітація сп’яніння за запитом людини.

За матеріалами: Wired

The post Люди платять за те, щоб їх чат-боти з ШІ ставали наркоманами appeared first on .